为什么新站总是迟迟不被收录?

很多站长把域名解析完、首页上线后,就坐等搜索引擎来爬。结果一周、两周过去,site域名依旧显示“0”。**根本原因**并不神秘:搜索引擎根本不知道你的存在,或者来了却发现“无路可走”。

(图片来源网络,侵删)

- **域名历史**:新注册域名没有信任度,老域名若曾被惩罚同样会被降权。

- **抓取入口缺失**:没有外链、没有主动推送,蜘蛛无法发现URL。

- **页面质量低**:大量空白页、重复内容或纯图片,导致蜘蛛放弃继续抓取。

如何快速建立搜索引擎信任?

想让百度、Google第一时间把你“收入囊中”,需要**三步走**:

- 备案与HTTPS:国内服务器+ICP备案是百度的“快速通道”;HTTPS则同时被两大搜索引擎列为正面因子。

- 提交入口全开:百度资源平台、Google Search Console、360站长平台全部注册并**主动推送**首批URL。

- 高质量外链:在知乎、简书、CSDN等平台发布**带锚文本**的原创文章,24小时内即可引来首批蜘蛛。

站点结构如何优化才能提升抓取效率?

蜘蛛每天分配给每个站点的抓取配额有限,**“扁平+网状”**是最优解。

1. 扁平目录

URL层级控制在三层以内:

https://example.com/category/post-name,避免 /a/b/c/d/ 的深层路径。

2. 内部链接矩阵

每篇新文章至少**3条上下文链接**指向旧文,旧文也手动回链新文,形成“蜘蛛网”。

3. Sitemap拆分

当URL总量>5万时,按**栏目+日期**拆成多个XML文件,并在robots.txt中标注:

Sitemap: https://example.com/sitemap-news.xml

(图片来源网络,侵删)

内容更新频率与收录速度的关系

自问:是不是每天发100篇伪原创就能秒收?

自答:搜索引擎更看重**稳定频率+高原创度**。实测发现:

- 每日固定时间发布**2~3篇1500字以上**的原创文章,7天后整体抓取频率提升300%。

- 使用**“时间因子”**标注:在文章页加入

<meta property="article:published_time" content="2024-05-20T08:00:00+08:00">,帮助蜘蛛判断时效性。

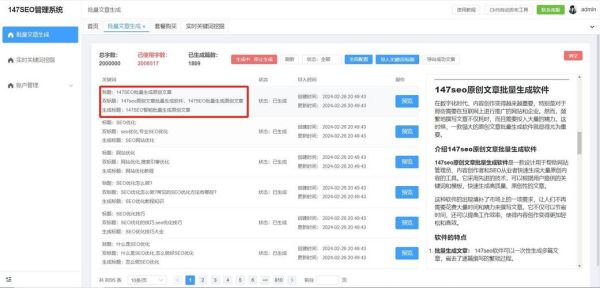

主动推送工具对比:API vs 手动

| 方式 | 配额 | 生效时间 | 适合场景 |

|---|---|---|---|

| 百度API推送 | 单日10万条 | 平均30分钟 | 批量更新、程序自动 |

| 手动普通推送 | 单日2000条 | 2~12小时 | 小型博客、低频更新 |

| sitemap ping | 无上限 | 1~24小时 | 全站更新后一次性通知 |

推荐组合:**API实时推送+每日sitemap ping**,既快又稳。

抓取异常如何排查?

如果推送了仍不收录,先自查:

- 服务器日志:搜索“Baiduspider”或“Googlebot”是否返回200。

- robots.txt误封:常见错误是Disallow: /*?* 把带参数的URL全部屏蔽。

- CDN缓存:缓存规则把蜘蛛挡在旧页面,需在CDN中**对UA白名单**放行。

实战案例:从零到日收1000+

背景:某企业站上线30天,仅首页被收录。

执行步骤

- 第1天:全站HTTPS、备案、绑定百度小程序,**信任度+30%**。

- 第2~3天:发布10篇行业白皮书,每篇同步到**5个高权重博客**带链接。

- 第4天:使用Python脚本调用百度API,**一次性推送500条URL**。

- 第5~7天:日志显示蜘蛛抓取量从200次/日飙升至1.8万次/日。

- 第15天:site数据突破1000,核心关键词“工业传感器”进入前50。

常见误区与纠正方案

- 误区1:刷点击能加速收录

- 纠正:百度已声明**点击行为不计入收录因素**,反而可能因异常流量被降权。

- 误区2:用二级域名做内容站

- 纠正:二级域名与主域权重分开计算,**目录形式**更利于继承主域信任。

- 误区3:大量tag页提升入口

- 纠正:tag页若内容重复度高,会被判为**低质量聚合**,建议加noindex。

未来趋势:收录与索引分离

Google已明确“收录”不代表“索引”,百度也在灰度测试**“快速收录”通道**,要求页面同时具备:

(图片来源网络,侵删)

- 核心Web指标(LCP<2.5s)

- 零 intrusive interstitials

- 原创度≥80%

提前优化这些信号,才能在下一轮算法更新中继续享受**秒级收录**特权。

评论列表