电信互联网业务支撑系统(BSS/OSS)是运营商完成“卖得了、装得快、修得好、算得准”的核心底座,它把网络能力与商业流程打通,让套餐订购、计费出账、故障处理、客户服务等环节自动化、智能化。下面用问答式拆解,让你一次看懂它是什么、怎么优化。

(图片来源网络,侵删)

一、电信互联网业务支撑系统到底是什么?

一句话:它是把“网络管道”变成“可售卖商品”的数字化中枢。

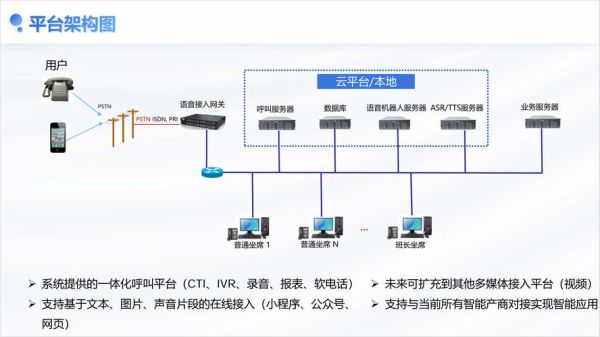

- 业务支撑域(BSS):CRM、计费、订单、支付、客服,解决“卖什么、怎么卖、收多少钱”。

- 运营支撑域(OSS):资源管理、故障管理、性能管理、激活开通,解决“网络怎么开、坏了怎么修”。

- 数据支撑域(DSS):数据湖、实时数仓、AI算法,解决“怎么洞察用户、怎么预测故障”。

二、运营商为什么年年都在升级这套系统?

因为业务场景在裂变:

- 从语音到流量再到云网融合,计费维度指数级增加;

- 从月付到日付、按时长、按位置、按切片,计费频次提升百倍;

- 政企专网、5G定制网、物联网卡,需要分钟级开通、秒级故障定位。

老系统“烟囱式”架构无法横向扩展,只能重构。

三、如何优化电信互联网业务支撑系统?六个实战步骤

1. 架构层面:从单体到微服务

痛点:一次需求上线=全量回归测试,窗口期两周。

解法:

(图片来源网络,侵删)

- 按“用户、产品、计费、资源”四大域拆微服务;

- 用Spring Cloud + Kubernetes做弹性伸缩,流量高峰自动扩容;

- 引入Service Mesh,灰度发布粒度从“系统级”降到“接口级”。

2. 数据层面:实时计费与离线计费并存

痛点:5G流量激增,话单峰值每秒千万条,Oracle撑不住。

解法:

- 话单入Kafka,Flink实时聚合,Redis做热点账户缓存;

- 历史详单入Hudi/Iceberg,支持分钟级回溯;

- 对账环节用ClickHouse做宽表,30亿条记录秒级查询。

3. 接口层面:开放API生态

痛点:政企客户要自研Portal,老系统只给FTP文件。

解法:

- 构建API Gateway,统一鉴权、流控、版本管理;

- 提供标准OpenAPI:套餐查询、订单创建、资源占用、故障报修;

- 用GraphQL让前端按需取字段,减少冗余传输。

4. 运维层面:可观测性三板斧

痛点:用户投诉“网速慢”,无法定位是无线侧还是支撑侧。

(图片来源网络,侵删)

解法:

- Tracing:在CRM、计费、激活全链路植入TraceID,Jaeger可视化;

- Metrics:Prometheus采集JVM、Kafka、Flink指标,Grafana告警;

- Logging:ELK集中日志,通过TraceID一键串联。

5. 安全层面:零信任+国密算法

痛点:政企专线开通接口暴露公网,易被刷号。

解法:

- API Gateway集成OAuth2.0+国密SM2双向证书;

- 内部微服务间mTLS通信,防止东西向攻击;

- 敏感字段用SM4加密落盘,密钥托管在HSM。

6. 组织层面:DevOps+FinOps双轮驱动

痛点:开发、运维、财务三拨人互相甩锅。

解法:

- 成立“业务SRE”团队,开发对SLI负责,运维对SLO负责;

- 每月FinOps例会,按微服务维度核算云成本,CPU利用率低于20%即缩容;

- 需求价值评估用WSJF模型,优先做“高价值×低成本”需求。

四、常见疑问快问快答

Q1:微服务拆到什么程度最合适?

A:遵循“两个披萨原则”,一个微服务团队吃两个披萨能吃饱,大约6-8人,对应1-2个业务能力域。

Q2:实时计费会不会导致余额抖动?

A:用预冻结+后冲正机制。用户订购10GB流量包,先冻结费用,实时扣减使用量,月底多退少补,避免频繁变动。

Q3:老系统数据怎么迁移?

A:三步走:

- 双写期:新系统同步写老系统,校验数据一致性;

- 灰度期:20%用户切到新系统,跑一个月无异常再全量;

- 下线期:老系统只读,保留三个月供审计。

Q4:如何衡量优化效果?

A:核心看三率一成本:

- 订单开通及时率≥99.5%

- 计费差错率≤0.001%

- 故障定位时长≤5分钟

- 单用户IT成本年降15%

五、未来三年演进方向

1. AI原生:用大模型自动生成测试用例、预测套餐流失;

2. 云网融合:支撑系统直接调用云网编排器,实现“云+网+应用”一体化开通;

3. 数字孪生:构建网络+业务的实时孪生体,故障前模拟影响范围。

把以上动作落地,电信互联网业务支撑系统就能从“成本中心”变成“增长引擎”。

评论列表