2024年服务器出货量还会增长吗?

根据IDC最新《服务器行业分析报告》,**2024年全球服务器出货量预计将达1380万台,同比增长6.4%**。驱动力主要来自三大块:AI训练集群扩张、云厂商CAPEX回暖、以及边缘节点补建。换句话说,只要GPU与ASIC仍供不应求,整机出货就不会掉头向下。

(图片来源网络,侵删)

AI服务器占比已突破多少?

报告给出的数字是18.7%,远高于去年的11.2%。其中:

- NVIDIA HGX平台占AI服务器总收入的62%

- 国产ASIC(含华为昇腾、寒武纪思元)份额首次突破15%

- 平均单价2.8万美元/台,为通用服务器的7倍

云厂商还是最大买家吗?

答案是肯定的,但格局出现微妙变化:

- 北美Hyperscaler(AWS、Azure、GCP)采购量占全球38%,较去年下降4个百分点;

- 中国Tier-1云(阿里、腾讯、百度、字节)逆势增长,份额升至21%;

- 电信运营商因5G专网与MEC需求,首次跻身前五。

边缘服务器为何突然加速?

报告用“**需求三角**”解释:

- 低延迟业务**:云游戏、工业视觉检测要求端到端<20ms;

- 数据合规**:欧盟GDPR、中国数据出境限制推动本地预处理;

- 网络成本**:回传流量费占OPEX比重从12%飙升至27%。

因此,**2024年边缘服务器出货量将达210万台,年增19%**,远超整体市场。

供应链瓶颈卡在哪里?

报告将风险分为三级:

(图片来源网络,侵删)

| 风险等级 | 关键部件 | 交期现状 | 潜在影响 |

|---|---|---|---|

| 高 | CoWoS封装产能 | 52周 | AI服务器延迟交付 |

| 中 | PMIC芯片 | 26周 | 通用服务器涨价5-8% |

| 低 | 机箱金属件 | 8周 | 区域缺货,可替代 |

液冷渗透率为何飙升?

2024年液冷服务器渗透率预计14.5%,而2022年仅4.3%。背后推手:

- TDP墙:单颗GPU功耗已突破700W,风冷极限400W/㎡;

- PUE红线:新加坡、北京要求新建数据中心PUE<1.15;

- CAPEX回收周期:液冷虽贵15%,但可节省30%电费,2.1年回本。

国产替代走到哪一步?h3>

从CPU、GPU到BMC,报告给出“**三横三纵**”进度:

- CPU:鲲鹏920、海光三号已在政务云规模部署,**x86替代率18%**;

- GPU:寒武纪MLU370、天数智芯BI-V100进入阿里PAI试商用;

- BMC/IPMI:龙芯2K1000+昆仑固件组合拿下三大运营商集采。

价格战会重演吗?

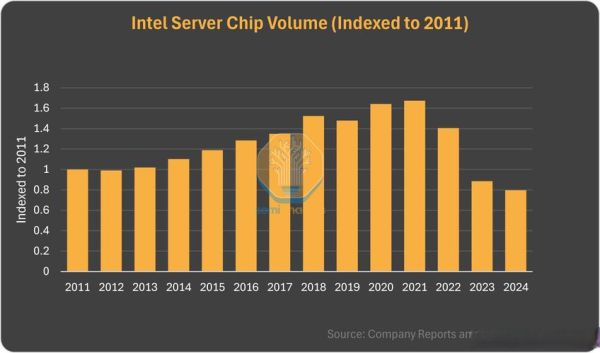

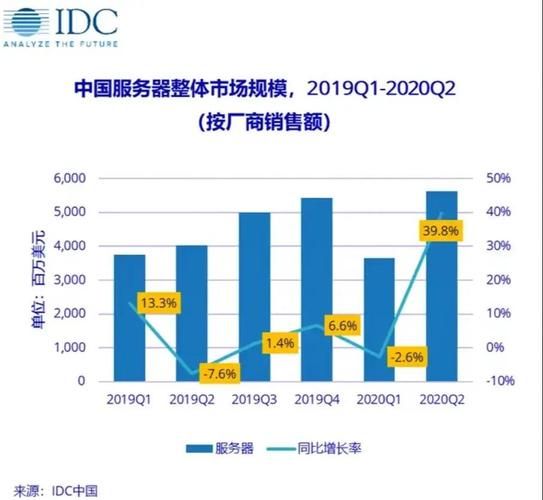

上一轮价格战发生在2019-2020年,通用服务器ASP跌幅达22%。2024年报告判断:

- AI服务器:GPU紧缺,厂商议价权强,**价格维持高位**;

- 通用服务器:Intel Sapphire Rapids、AMD Genoa同代竞争,**ASP或下滑8-10%**;

- 边缘服务器:形态碎片化,**价格战概率最低**。

投资视角:谁是下一个“隐形冠军”?

报告用“**收入弹性/估值水位**”二维矩阵筛选出三类标的:

- 液冷快接头:技术壁垒高,全球仅3家能量产,毛利率>45%;

- 国产BMC芯片:单价低但用量大,每台服务器1颗,市场容量2.5亿美元;

- 服务器电源:800W-3kW CRPS标准升级,GaN方案渗透率有望从5%到30%。

用户该如何选型?

自问自答三个最常被问到的问题:

(图片来源网络,侵删)

Q:AI推理场景必须买HGX吗?

A:不一定。如果模型<10B参数,**国产ASIC+FP16精度**已能满足,TCO可降40%。

Q:边缘节点选x86还是ARM?

A:看软件栈。若应用基于Docker且已适配ARM,**鲲鹏或Ampere Altra**可节省15%功耗。

Q:液冷改造旧机房可行吗?

A:楼板承重需≥1200kg/㎡,且需预留CDU占地。若无法满足,**可选后门热交换器**过渡方案。

评论列表